论文链接

Abstract

目前,中文序列标注任务中有很多预训练模型(BERT)与词汇信息的探索工作。然而,大多工作只是将词汇信息通过浅层的网络(随机初始化)编码,并没有将其集成到BERT的底层网络中。本文我们提出了Lexicon

Enhanced BERT (LEBERT) ,使用Lexicon Adapter layer将外部词汇信息集成到BERT中。我们的模型促进了外部知识在BERT底层网络中的融合,在中文NER、分词、词性标注等任务中,得到了SOTA的结果。

1 Introduction

目前有两个主线用于增强字符级别的中文NER方法,第一种认为将此信息集成到基于字符的序列编码器中,以便可以明确建模字特征。第二种考虑集成大规模的预训练文本向量,eg:BERT;使用隐式词级别的语义知识。

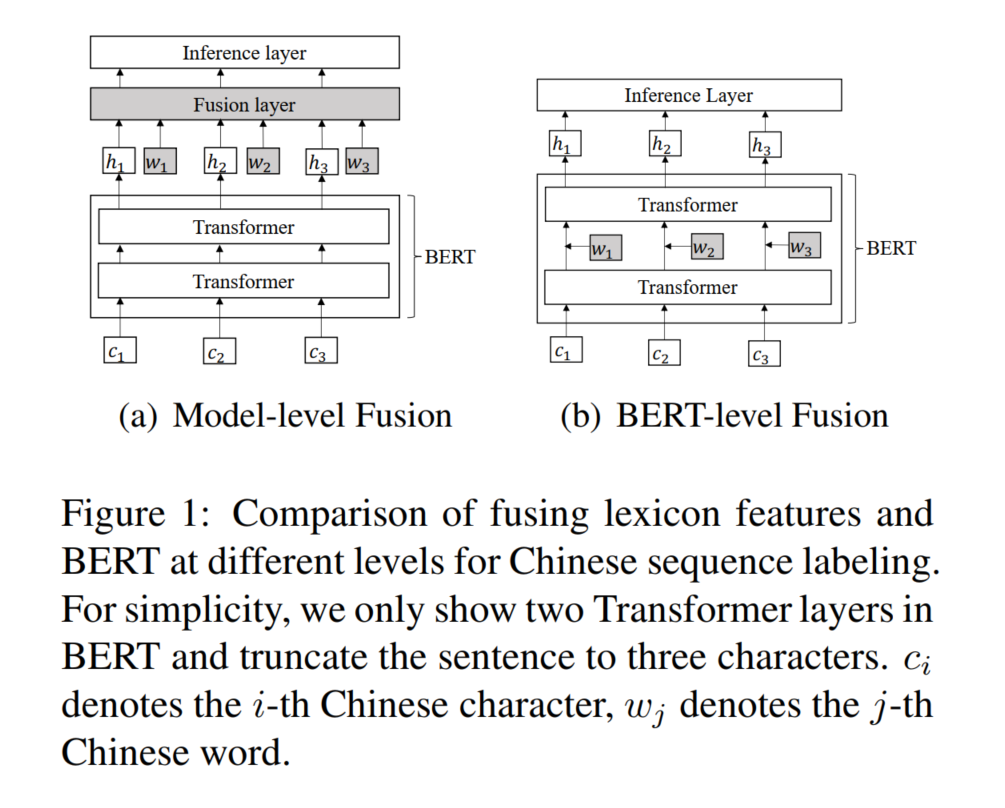

最近主要的思路是从BERT获取全文表示和词汇特征到一个神经序列标注模型,如下图1a,然而这种方式没有完全开发BERT的表示能力,因为外部特征没有集成到底层。

我们提出LEBERT,具体而言,通过将句子与现有的词典匹配,中文句子转换为char-words序列。然后设计一个词汇Adapter去为每个字符抽取最相关匹配的词通过一个char-to-word的Bilinear注意力机制。如图1b。在训练期间同时微调BERT与词汇Adapter。

2 Related Work

Lexicon-based. 目标是加强字符模型与词汇信息的融合,比如lattice-LSTM,词汇信息在中文分词和词性标注任务中是有效的。

Pre-trained Model-based.比如BERT+Softmax等

Hybrid Model集成词汇信息与预训练模型从而利用他们各自的长处。一般是通过将BERT表示和词汇信息拼接输入到一个浅层网络中。ERNIE、ZEN都尝试对预训练模型在词汇粒度信息融入。

BERT Adapter该模块主要去学习下游特定任务的参数。具体地说,它们在预先训练好的模型的层之间添加适配器,并仅为特定任务调整添加的适配器中的参数。MAD-X、K-ADAPTER

3 Method

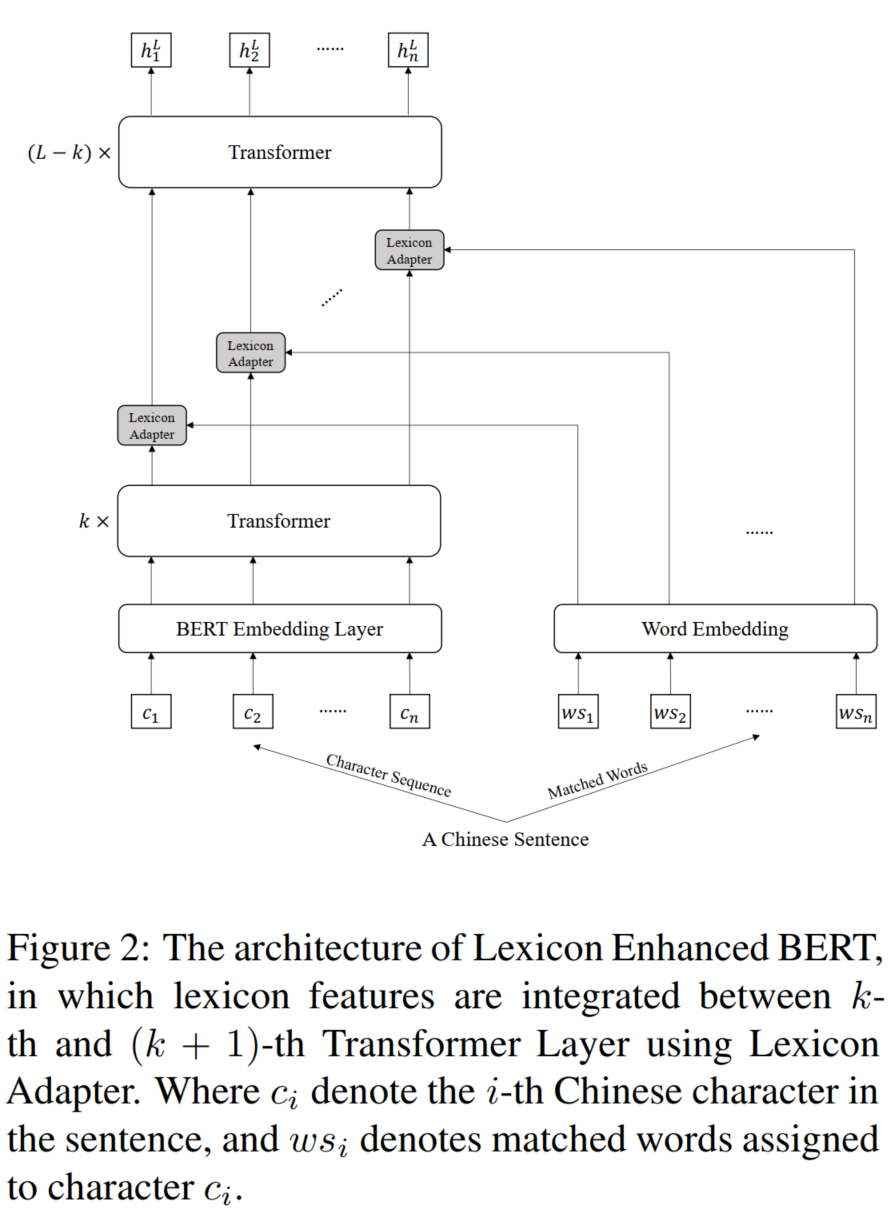

模型主要结构如上图所示。LEBERT相对BERT有两点不同,第一,将中文句子的字符和词汇特征转为字符-词汇pair对同时输入到模型。第二,在Transformer层之间使用词汇adapter,将词汇知识集成到BERT中。

3.1 Char-Words Pair Sequence

给定一个词汇表D和一个中文句子$s_c=\{c_1,c_2,...c_n\}$。我们通过将字符序列与D匹配,找出句子中所有的潜在单词,具体来说,我们首先基于D构建一个前缀树,然后遍历句子的所有字符子序列,并将它们与前缀树匹配,以获得所有潜在单词。如下图3所示,最终获得到$s_{cw}=\{(c_1,ws_1),(c_2,ws_2),...(c_n,ws_n)\}$,ci为句子中第i个字符,wsi为ci相匹配的词汇。

3.2 Lexicon Adapter

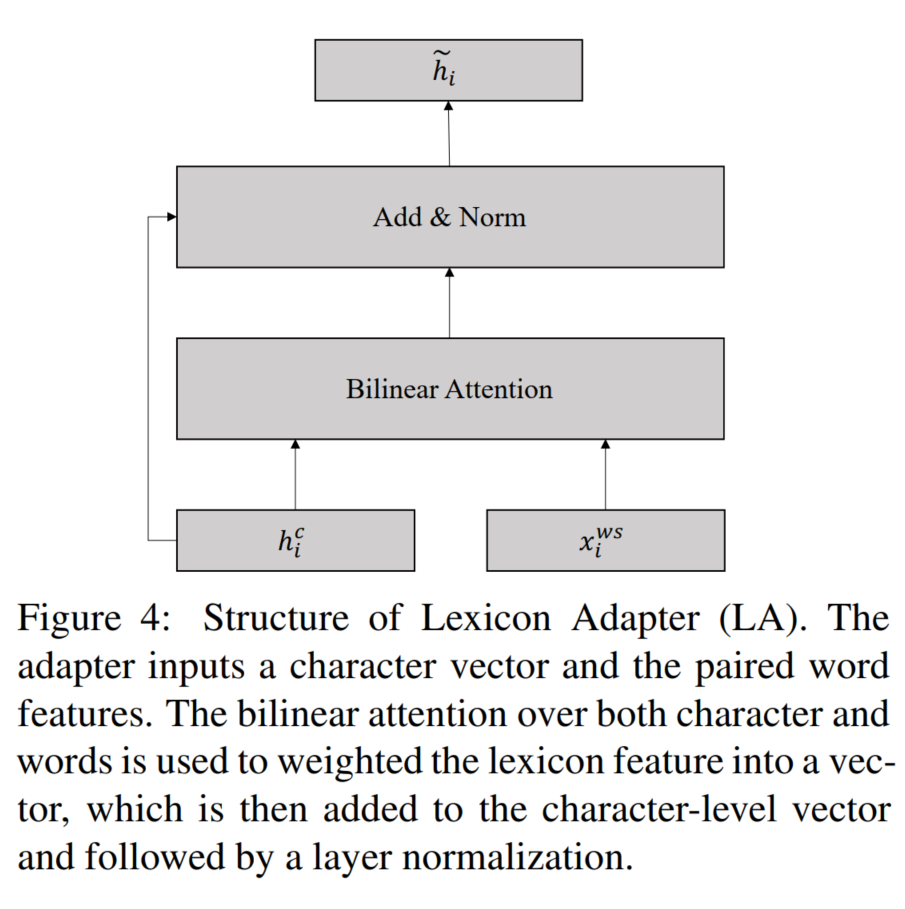

句子中的每个位置有两种信息组成,字符级特征和词汇级特征。如下图4,我们提出Lexicon Adapter在BERT中直接注入词汇信息。

为了对齐两种不同的表示,我们应用了一个非线性变换。由于每个字符可能对应了多个词语,并且多个词在不同任务中的重要性不同,我们使用了一个char-to-word的注意力机制。

3.3 Lexicon Enhanced BERT

Lexicon Adapter(LA)放置在BERT的transformer层中间,注入外部知识到BERT中。在正常的token embedding输入到Transformer层得到${h^k_1}$之后,我们将每对${(h^k_i,x^{ws}_i)}$传入到LA,最终经过多层编码后,拿出最后的表示H进行序列标注任务。

3.4 Training and Decoding

使用CRF去完成序列标注任务。

4 Experiments

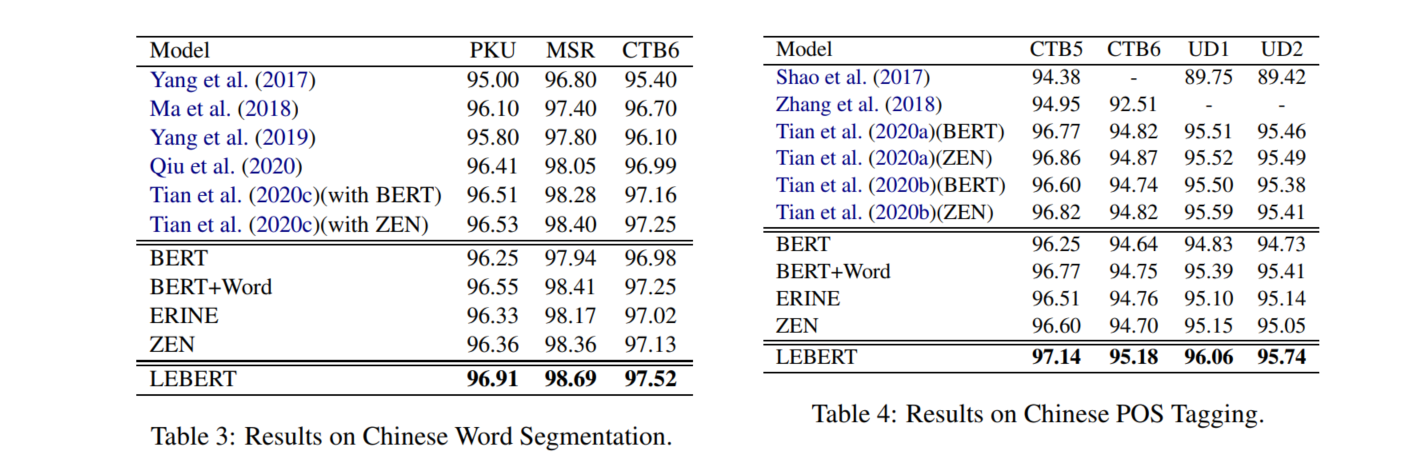

在中文NER、分词、词性标注等任务上实验,对比模型BERT、BERT-word、ERNIE、ZEN等,具体结果直接看下表吧,

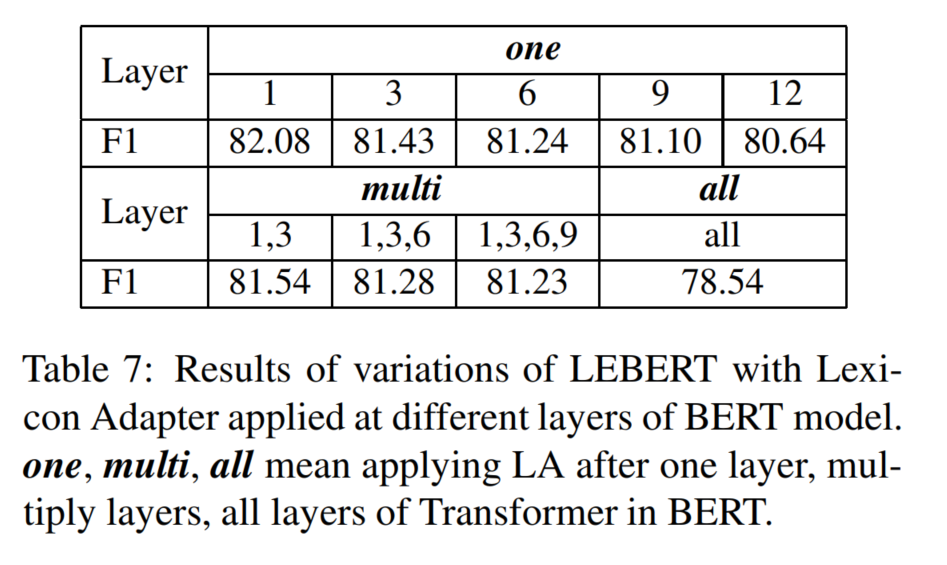

作者探索了LA使用在单层、多层、所有层Transformer的效果,结果如下,单层效果相对较好,这可能是因为浅层促进了词典特征和文本之间更分层的交互。

5 Conclusion

本文提出LEBERT,在Trasformer layer中集成词汇信息,与模型级别的集成方法对比,LEBERT在BERT级别进行了词汇信息与BERT表示的深度融合。在三个中文序列标注任务中,拿到了SOTA。