论文链接

Abstract

答案选择和知识库问答(KBQA)是问答(QA)系统的两个重要任务。现有方法分别分开解决这两个任务,这需要大量的重复工作,而忽略了任务之间的丰富的相关信息。在本文中,我们基于以下动机,通过多任务学习(MTL)同时解决答案选择和KBQA任务。首先,答案选择和KBQA都可以视为排序问题,一个在文本级别,另一个在知识级别。其次,这两个任务可以互惠互利:答案选择可以结合知识库(KB)中的外部知识,而KBQA可以通过从答案选择中学习上下文信息来进行改进。为了实现共同学习这两个任务的目标,我们提出了一种新颖的多任务学习方案,该方案利用从各个角度学习到的多视图注意力来使这些任务能够相互交互以及学习更全面的句子表示形式。在多个真实的数据集上进行的实验证明了该方法的有效性,并提高了答案选择和KBQA的性能。同样,从不同的表示角度来看,多视图注意力方案在组合注意力信息方面被证明是有效的。

Introduction

多任务学习在NLP领域是广泛的,然而QA中的MTL研究较少。本文中,我们探索了利用MTL去同时处理答案选择和KBQA,这两种任务都可以视为排序任务,一个在答案文本级别,另一个是知识级别。答案选择是在多个答案片段中选出一个最合适的答案,KBQA专注于在KB中抽取出相关的知识,去回答问题。

大多多任务学习模块,划分共享层和特殊任务层,共享层在各个任务中共享信息,特殊任务层对不同任务是不同的。大多模型忽视了共享层和特殊任务层之间的交互,并且忽视了不同任务之间的交互。因此,本文提出了MTL从不同方面去学习多视角的attention,能够使不同的任务互相交互。具体而言,我们从任务特定的层中收集注意力信息,以在共享层中学习更全面的句子表示形式。 此外,多视图注意力机制通过结合单词级和知识级信息来增强句子的表示学习。 也就是说,通过使用多视图注意力机制,可以在不同任务之间共享和传输单词级和知识级的注意力信息。

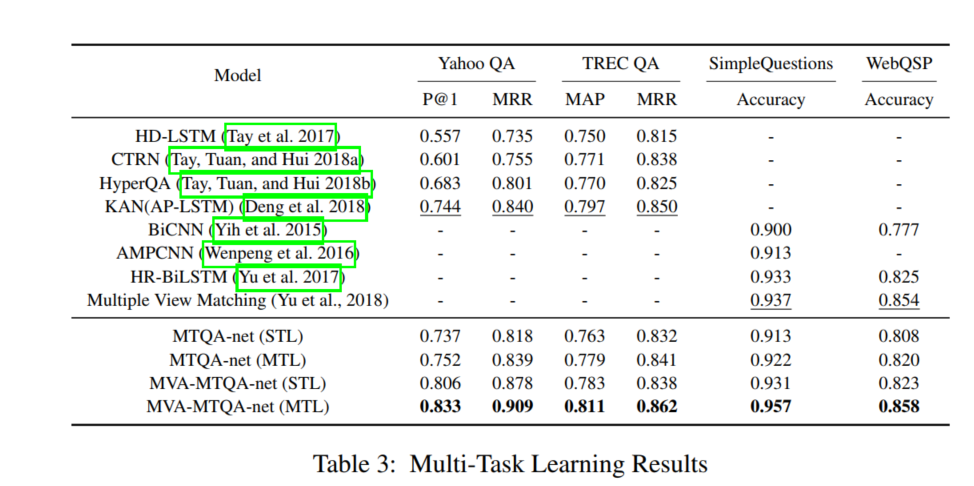

根据实验,与单独答案选择和KBQA任务相比,联合学习可以显着提高每个任务的性能。 实验结果还表明了多视图注意力方案的有效性,并且每个视图的注意力都做出了贡献。本文主要贡献如下:

- 我们探索用于选择答案和知识库问题解答的多任务学习方法。 知识级别的KBQA任务可以改善答案选择任务,而词汇级别的答案选择任务可以增强KBQA任务。

- 我们提出了一种新颖的多任务学习方案,该方案利用多视图注意力机制来桥接不同的任务,该任务将特定于任务的层的重要信息集成到共享层中,并使模型能够交互式地学习单词级别和知识 级表示。

- 实验结果表明,答案选择和KBQA的多任务学习优于最新的单任务学习方法。 此外,基于多视图注意力的MTL方案进一步提高了性能。

Multi-Task Learning for Question Answering

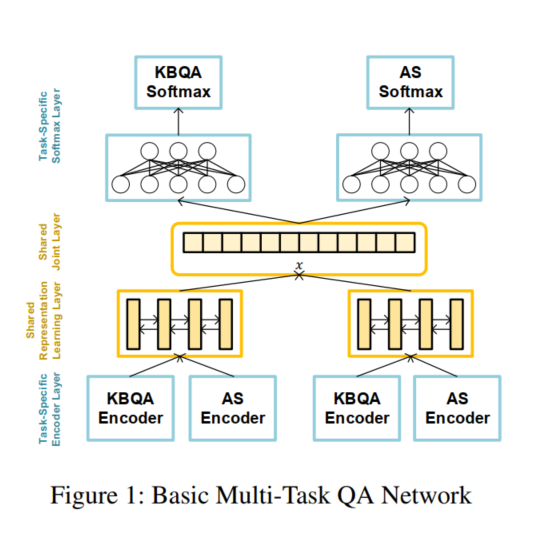

图一为多任务QA网络的架构(包含AS和KBQA)。

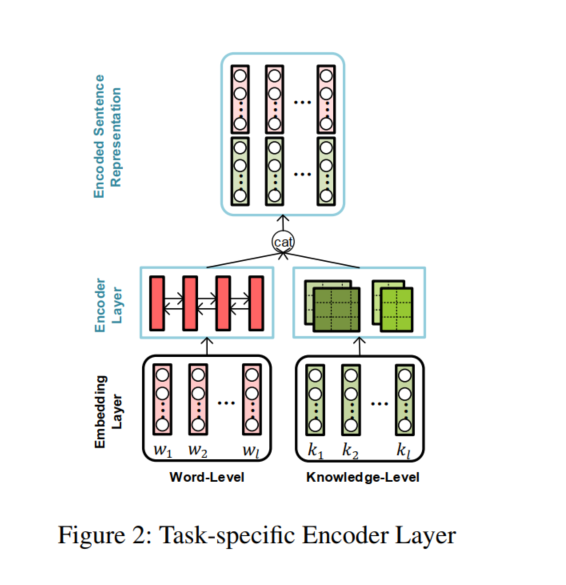

Task-specific Encoder Layer 首先将预处理后的句子编码成向量表示。不同的QA任务在数据分布和底层表示上应该是不同的。因此,每个任务都配备了一个用于问答的特定任务编码器,每个特定任务编码器都包含一个单词编码器和一个知识编码器来学习完整的句子表示,如图2所示

Word Encoder. 输入为词向量,使用BiLSTM去捕获全文信息,得到Hw。

Knowledge Encoder. 由于知识序列是由一系列标记化的实体或关系名称组成的,因此后一种学习过程需要基于高级知识的表示。针对这一问题,我们将CNN应用到知识序列上,其中大小为n的filters在知识嵌入矩阵上滑动以捕获局部n-gram特征,每次移动都会计算一个隐藏层向量。由于实体长度不确定,因此,会使用不同大小的卷积核来计算,然后使用Dense层来获取知识表示Hk

将Hk和Hw进行拼接,$H_q=[H_{W_q}:H_{K_q}]$,$H_a=[H_{W_a}:H_{K_a}]$,分别为问题和答案的隐藏表示。

Shared Representation Learning Layer

与任务特定编码层的输入相比,整句表示具有更丰富的语义,与其他任务的分布更相似。因此,我们整合来自所有任务的编码向量,并通过一个高级共享的Siamese-Bi-LSTM来生成最终的QA表示$S_q$和$S_a$,然后进行平均池化,并且使用了一些词级别特征$x_{ol}$,最终表示为$x=[s_q,s_a,x_{ol}]$

Task-specific Softmax Layer 使用softmax最终分类。

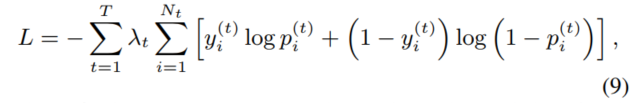

Multi-Task Learning

最小化以上目标函数,$\lambda$为不同任务的权重

Multi-Task Model with Multi-View Attention

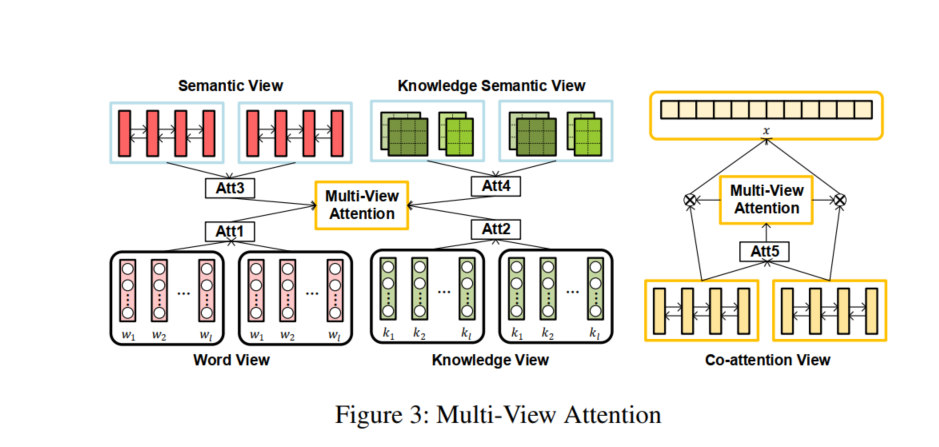

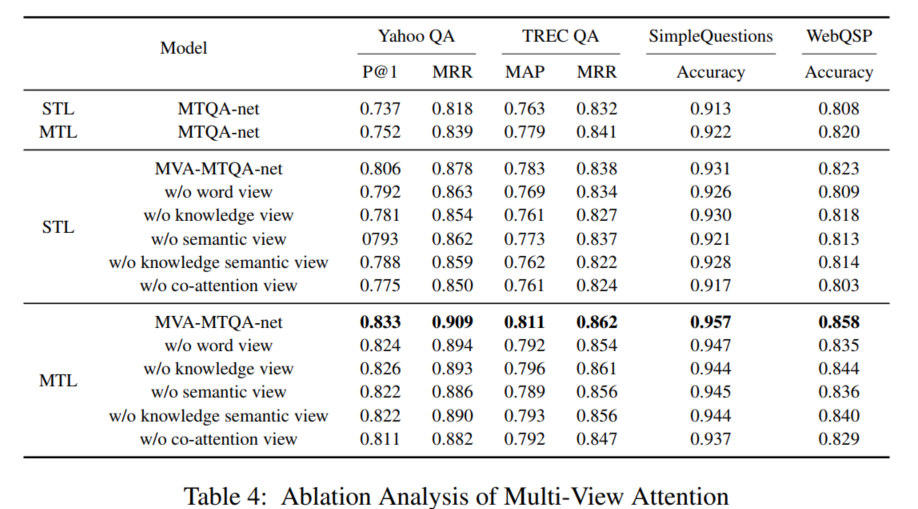

为了增强潜在表征空间中不同QA任务之间的交互作用,我们提出了一种多视角注意机制,从任务特定层和共享层提取重要信息。

Multi-View Attention Scheme

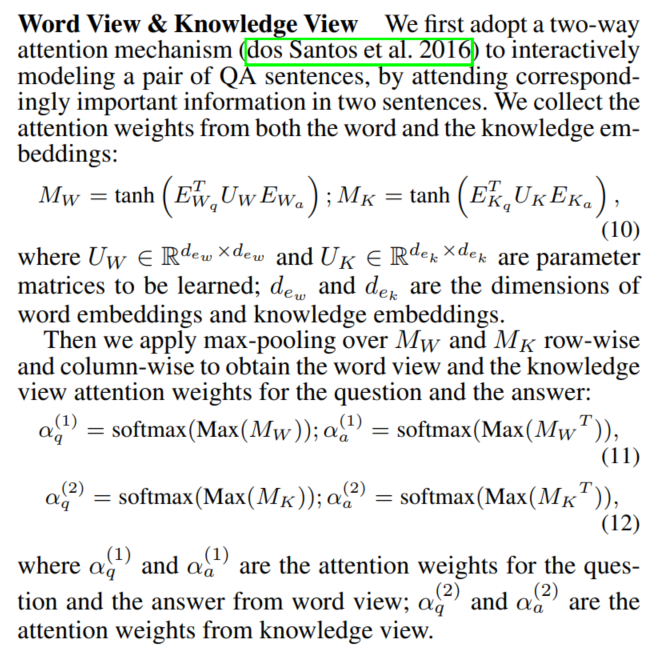

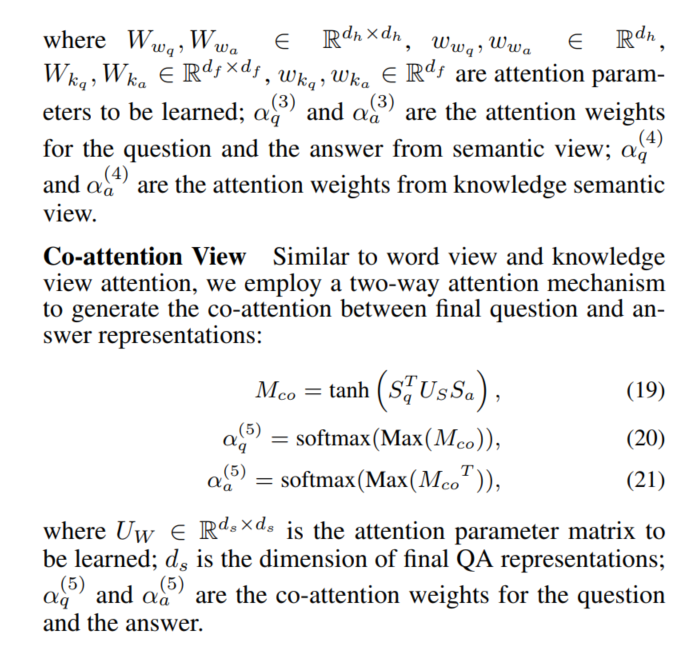

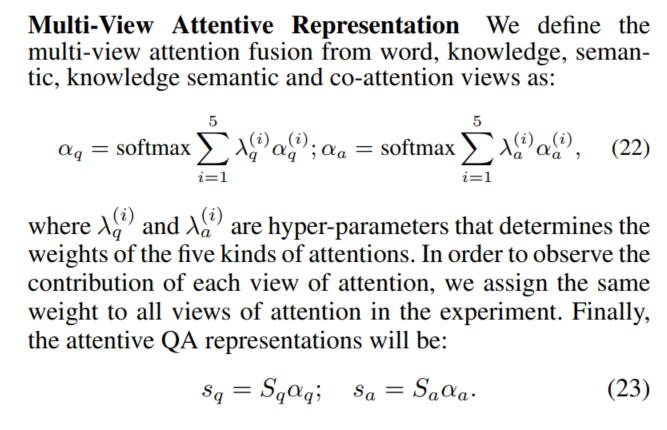

如图3所示,与其他注意共享方案不同的是,我们不仅从任务特定层提取注意力,而且还将来自共享层的信息进行组合。此外,我们从词汇和知识两个角度获得注意信息,因为词汇水平和知识水平的信息可能共同促进表示学习。具体来说,我们计算了五种注意观,包括词、知识、语义、知识语义和共同注意力。

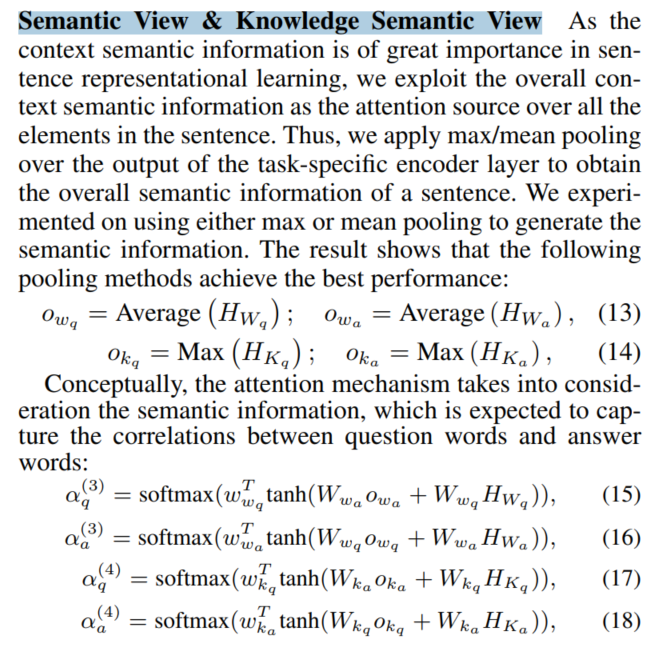

Semantic View & Knowledge Semantic View使用mean/max池化去获取句子的语义表示

Experiment

Datasets & Preprocessing

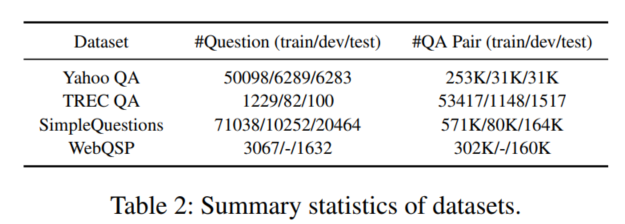

AS: YahooQA,TREC QA

KBQA: SimpleQuestions,WebQSP

Multi-Task Learning Results

Related Work

Answer Selection

Multi-Task Learning

Conclusion

本文研究了同时解决答案选择和知识库问答问题的多任务学习方法。我们提出了一种新的多任务学习方案,该方案利用从不同角度学习的多视角注意,使这些任务能够相互作用,并学习更全面的句子表示,包括词视角、知识视角、语义视角、知识语义视角和共注意力视角。在几个广泛使用的QA基准数据集上进行的实验表明,答案选择和知识库问答的联合学习方法明显优于单任务学习方法。同时,多视角注意策略能有效地从不同的表征视角收集注意信息,提高整体表征学习效果。